spark为什么会出现堆外内存不足

Spark在进行内存管理时,默认使用JVM堆内存和堆外内存。堆外内存是指非JVM堆内存,它通常用于缓存数据和执行直接内存访问的操作。Spark中,堆外内存主要用于存储数据序列化后的结果和网络IO。

如果Spark程序使用的堆外内存超过了系统限制或者没有足够的可用空间,则会出现堆外内存不足的情况。这种情况下,Spark无法继续执行任务,可能会导致程序崩溃。

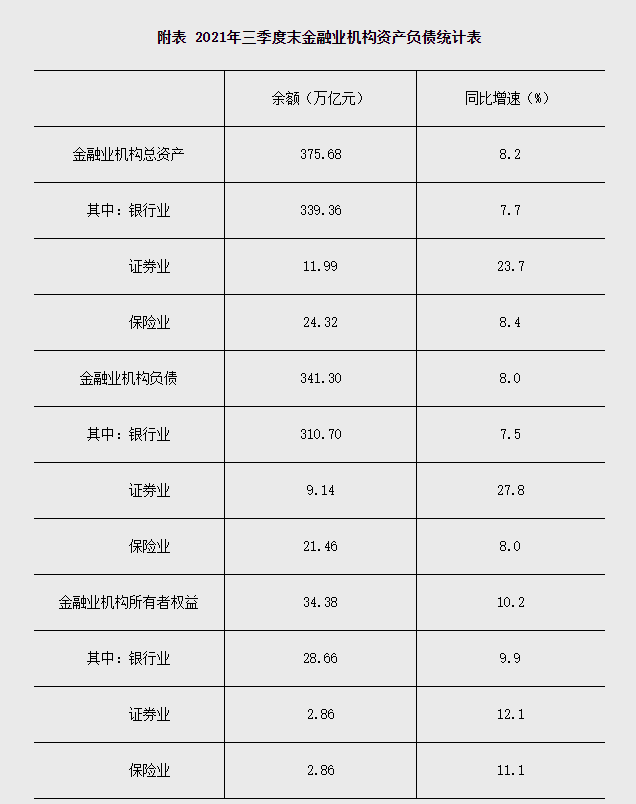

(资料图片仅供参考)

(资料图片仅供参考)

以下是可能导致堆外内存不足的原因:

Spark程序处理的数据量过大,超出了系统可用的堆外内存空间。

系统中存在其他应用程序占用了过多的堆外内存空间,导致Spark无法分配足够的内存。

配置参数错误,例如设置的Spark内存大小过小,导致Spark无法分配足够的堆外内存。

为解决堆外内存不足问题,可以通过以下方式进行优化:

调整Spark程序的内存配置,增加堆外内存的分配量。

优化Spark程序的算法和逻辑,减少数据处理量和内存占用。

对系统进行优化,关闭不必要的应用程序,释放堆外内存空间。

使用更高效的数据存储格式,例如使用二进制格式代替文本格式,可以减少序列化后的数据占用空间。

增加系统的物理内存或者交换空间,增加堆外内存的可用空间。

关键词:

-

spark为什么会出现堆外内存不足

2023-04-23 -

可决系数怎么来的(可决系数)-全球视点

2023-04-23 -

【天天热闻】女单连夺4冠!陈梦接班人大爆发,比孙颖莎小6岁,国乒再获天才

2023-04-23 -

win7开机密码查看器_win7怎么查看电脑开机密码

2023-04-23 -

俞敏洪:人生最大遗憾是没有留学 并建议董宇辉留学_天天热闻

2023-04-23 -

湖南怀化“85后”返乡青年让农产品“种得好”“卖得俏” 天天快资讯

2023-04-23 -

王艳阳_王燕阳_全球短讯

2023-04-22 -

丽日丽作品封面 丽日丽 全球微头条

2023-04-22 -

精彩看点:据彭博社当地时间4月21日报道,加拿大TC能源公司称,去年该公司“拱心石”(Keystone)石油管道发生的重大泄漏事故是由管道老化出现裂纹造成的

2023-04-22 -

“中国好故事”网络国际传播精品案例评选结果公布

2023-04-22 -

全球聚焦:广西壮族自治区龙胜各族自治县发布暴雨橙色预警

2023-04-22 -

全球播报:山西煤炭运销集团吕梁有限公司

2023-04-22 -

全球今热点:重庆:2000名参赛者齐聚明月湖畔角逐健康跑与欢乐跑

2023-04-22 -

4平方电线可以带多少千瓦_4平方线能带多少千瓦 世界快资讯

2023-04-22 -

金铲铲之战S8.5星守灵能妮蔻怎么玩_星守灵能妮蔻阵容搭配攻略[多图] 当前观察

2023-04-22 -

当前视点!江门4批次食品抽检不合格,大润发新会店一食品铅超标近2倍

2023-04-22 -

友阿海外购的真假_友阿海外购的东西是正品

2023-04-22 -

环球热头条丨山西省阳泉市委常委、组织部部长金所军被查

2023-04-22 -

今日观点!熨帖的读音微课_熨帖的读音

2023-04-22 -

每日快播:拜登将签令限制美企对华关键经济领域投资?外交部:坚决反对

2023-04-22 -

“医药女神”葛兰一季度规模跌破900亿:依然看重行业创新 加仓恒瑞医药(600276.SH)|资讯

2023-04-22 -

发财树修剪_发财树的修剪 天天精选

2023-04-22 -

端午节教师祝福语_端午节教师祝福语精选

2023-04-22 -

如果我是什么我将什么英语作文_如果我是什么我将什么

2023-04-22 -

研究生毕业才知道,“学硕”和“专硕”差距明显,难怪有人会后悔_环球即时

2023-04-22 -

班组天地 | 听,班组里的读书声

2023-04-22 -

人一生不要瞎忙,首先做对四件事! 世界要闻

2023-04-22 -

惊了!这只股票崩了 前1天一度飙涨超1100%!_观点

2023-04-22 -

长相年轻的人,一定是个福星!

2023-04-22 -

碳酸锂价格跌势放缓 厂商坦言市场已有活跃迹象

2023-04-22

-

知识分享 笔记本电脑保养方法是什么

2023-01-16 -

守住网络直播的伦理底线

2021-12-16 -

石窟寺文化需要基于保护的“新开发”

2021-12-16 -

电影工作者不能远离生活

2021-12-16 -

提升隧道安全管控能力 智慧高速让司乘安心

2021-12-16 -

人民财评:提升消费体验,服务同样重要

2021-12-16 -

卫冕?突破?旗手?——武大靖留给北京冬奥会三大悬念

2021-12-16 -

新能源车险专属条款出台“三电”系统、起火燃烧等都可保

2021-12-16 -

美术作品中的党史 | 第97集《窗外》

2021-12-16 -

基金销售业务违规!浦发银行厦门分行等被厦门证监局责令改正

2021-12-16